Was ist RAG (Retrieval-Augmented Generation)?

Wie RAG funktioniert: die Technologie, die Large Language Models mit aktuellen und kontextbezogenen Informationen verbessert

In der sich rasant entwickelnden Welt der Künstlichen Intelligenz haben Large Language Models (LLMs) beeindruckende Fähigkeiten gezeigt, kohärente und kontextuell relevante Texte zu generieren. Doch selbst die fortschrittlichsten Modelle können mit Problemen wie sogenannten „Halluzinationen“ (plausible, aber falsche Informationen) oder der Begrenzung auf das im Training erlernte Wissen konfrontiert werden.

Genau hier kommt die Retrieval-Augmented Generation (RAG) ins Spiel – eine innovative Technik, die unsere Interaktion mit LLMs revolutioniert, indem sie diese präziser, verlässlicher und aktueller macht. RAG entwickelt sich zu einem zentralen Ansatz beim Aufbau von Konversationssystemen, intelligenten Assistenten und Frage-Antwort-Systemen, die die Leistungsfähigkeit großer Sprachmodelle mit dem Zugriff auf externe Wissensquellen kombinieren.

In diesem Artikel werfen wir einen genaueren Blick darauf, was RAG ist, wie es funktioniert, warum es so relevant ist und worin es sich von Techniken wie der semantischen Suche unterscheidet.

Inhaltsverzeichnis

Was ist Retrieval-Augmented Generation (RAG)?

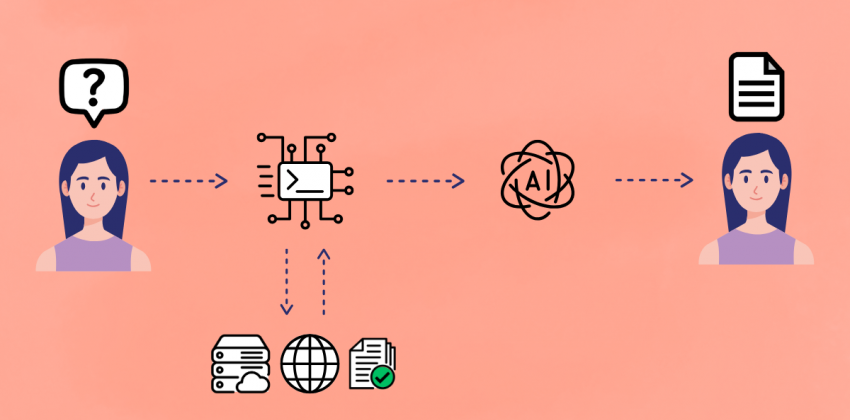

Retrieval-Augmented Generation (RAG) ist eine Technik, die die Fähigkeit von Sprachmodellen verbessert, präzise und fundierte Antworten zu generieren, indem sie Informationen aus einer externen, verlässlichen Wissensquelle abruft, bevor die endgültige Antwort erstellt wird.

RAG kombiniert zwei zentrale Komponenten der natürlichen Sprachverarbeitung:

- Retrieval (Abruf): Zugriff auf eine externe Wissensdatenbank (z.?B. Dokumente, Datenbanken oder Artikel), die in Bezug auf eine Anfrage oder einen Prompt relevant ist;

- Generation (Generierung): Erstellung einer kohärenten und kontextbezogenen Antwort mithilfe eines Sprachmodells (meist ein LLM), das mit den abgerufenen Informationen arbeitet.

Statt sich ausschließlich auf das im Training „gespeicherte“ Wissen zu stützen, sucht RAG aktiv nach relevanten Daten in Dokumentensammlungen, Datenbanken oder im Web und nutzt diese als zusätzlichen Kontext, um die Generierung des LLM zu leiten – und dadurch Genauigkeit, Aktualität und Relevanz der Antworten zu verbessern.

Wie funktioniert Retrieval-Augmented Generation?

Der RAG-Prozess lässt sich in fünf Hauptphasen unterteilen:

- Indexierung – Externe Daten werden in numerische Repräsentationen (Embeddings) umgewandelt. Diese Embeddings erfassen die semantische Bedeutung der Inhalte und werden in Vektordatenbanken gespeichert, die auf Ähnlichkeitssuche optimiert sind.

- Query-Embedding – Wenn der Nutzer eine Anfrage stellt, wird diese in einen numerischen Vektor umgewandelt – mit demselben Modell, das auch zur Kodierung der Dokumente verwendet wurde.

- Dokumentenabruf – Der Query-Vektor wird verwendet, um in der Vektordatenbank nach semantisch ähnlichen Dokumenten oder Textfragmenten zu suchen. So werden rasch die relevantesten Informationen zur Anfrage identifiziert.

- Augmentation – Die abgerufenen Informationen werden dem LLM zusammen mit der ursprünglichen Nutzeranfrage als zusätzlicher Kontext bereitgestellt.

- Konditionierte Generierung – Das LLM, nun ergänzt durch aktuelle und spezifische Informationen, nutzt sowohl sein internes Wissen als auch den bereitgestellten Kontext, um eine genauere, relevantere und „halluzinationsfreie“ Antwort zu erstellen. Dabei werden die Inhalte nicht nur umformuliert, sondern auch zusammengefasst, neu strukturiert und in eine natürliche Antwort integriert.

RAG und große Sprachmodelle (LLMs)

LLMs wie GPT-4 oder Claude verfügen über große Generalisierungsfähigkeiten, können natürliche Sprache verstehen, zusammenfassen, übersetzen und generieren – sind aber begrenzt durch den Trainingszeitraum und die Menge an Tokens, die sie speichern können. Ihre Kenntnisse beschränken sich auf die Daten, mit denen sie trainiert wurden – oft veraltet oder nicht domänenspezifisch.

Mit dem RAG-Ansatz lassen sich diese Grenzen überwinden:

- Zugriff auf aktuelle Informationen in Echtzeit (z.?B. Nachrichtenartikel, Unternehmensdatenbanken, interne Dokumente);

- Reduzierung von Halluzinationen – also falschen oder erfundenen Aussagen;

- Verringerung von Bias, der aus den Trainingsdaten stammt;

- Antworten auf domänenspezifische Fragen (z.?B. aus unternehmensinterner Dokumentation) ohne erneutes Training des Modells;

- Möglichkeit, Quellenangaben zu den verwendeten Informationen einzufügen – für mehr Transparenz und Vertrauen.

Kurz gesagt: RAG erweitert das Gedächtnis von LLMs und macht sie zu verlässlicheren, individuell anpassbaren Werkzeugen zur Recherche und Textgenerierung.

Was ist der Unterschied zwischen RAG und semantischer Suche?

Beide Techniken basieren auf dem semantischen Abruf von Inhalten, verfolgen jedoch unterschiedliche Ziele:

| Merkmal | Semantische Suche | Retrieval-Augmented Generation |

|---|---|---|

| Output | Liste von Dokumenten oder Fragmenten | Generierte Antwort in natürlicher Sprache |

| Generierungsmodell | Nicht vorhanden | Vorhanden (z.?B. LLM wie GPT, BART) |

| Zielsetzung | Lesen und Navigation durch den Nutzer | Autonome, formulierte Systemantwort |

| Personalisierung | Begrenzt | Hoch: anpassbar an Domäne oder Kontext |

Die semantische Suche zielt darauf ab, die relevantesten Dokumente zu einer Anfrage auf Basis ihrer Bedeutung zu finden. RAG hingegen geht einen Schritt weiter: Es fasst die Informationen zusammen und stellt sie in den Kontext – das Ergebnis wirkt eher wie ein Gespräch mit einem Experten.

Warum RAG verwenden – und warum ist es so wichtig?

Die Bedeutung von Retrieval-Augmented Generation ergibt sich aus mehreren zentralen Vorteilen:

- Aktueller Kontext

Antworten basieren auf aktuellen Inhalten – ohne dass das Modell neu trainiert werden muss. - Verifizierbare Quellen

Die generierten Inhalte lassen sich zurückverfolgen und mit echten Dokumenten belegen. - Reduktion von Halluzinationen

Externer Kontext „erdet“ das LLM in der Realität. - Domänenspezifisch & anpassbar

RAG erlaubt die flexible Integration von Unternehmens-, Fach- oder wissenschaftlichen Wissensbasen. - Kosteneffizienz

Günstiger als ein Fine-Tuning zur Wissensaktualisierung.

RAG ist daher ideal in Anwendungen, bei denen Präzision, Aktualität und Nachvollziehbarkeit gefragt sind.

Mögliche Einsatzfelder

Die RAG verändert bereits die Art und Weise, wie wir mit KI in verschiedenen Bereichen interagieren, zum Beispiel:

- Medizin: Assistierte Diagnostik durch Abruf aus klinischen Forschungsdatenbanken;

- Recht: Vertragsanalysen unter Berücksichtigung aktueller Gesetze;

- Wissenschaft: Q&A zu wissenschaftlichen Publikationen;

- IT-Support: Assistenten, die technische Probleme mit Hilfe interner Dokumentation und Wissensdatenbanken lösen.

RAG in Chat-Anwendungen nutzen

Immer mehr fortschrittliche Chatbot-Systeme – etwa in den Bereichen Recht, Medizin oder Kundenservice – setzen auf die RAG-Architektur, um:

- Gezielte Antworten auf Basis technischer Handbücher, Vorschriften oder aktueller Ereignisse zu liefern;

- Konversationen auf den Nutzer oder das Unternehmen zuzuschneiden;

- Inhalte laufend zu aktualisieren, ohne das Modell selbst ändern zu müssen.

In der Praxis verwandelt RAG einen allgemeinen Chatbot in einen spezialisierten, intelligenten Agenten.

Welche Vorteile bietet Retrieval-Augmented Generation?

Hier eine Zusammenfassung der wichtigsten Vorteile von RAG:

- Zugriff auf externe, aktuelle Informationen

- Reduktion typischer LLM-Halluzinationen

- Flexibilität und Skalierbarkeit über verschiedene Datenquellen hinweg

- Quellen-Nachverfolgbarkeit

- Höhere Qualitätskontrolle bei Antworten

- Nahtlose Integration in bestehende Architekturen (z.?B. APIs, Wissensdatenbanken)

RAG stellt einen evolutionären Schritt für LLMs dar und verwandelt sie von „statischen Enzyklopädien“ in dynamische Systeme mit kontextuellem Lernvermögen. Dank der Kombination aus intelligenter Informationssuche und fortschrittlicher Textgenerierung wird RAG zum neuen Standard in Enterprise- und Consumer-Anwendungen, in denen Genauigkeit und Aktualität entscheidend sind.