Openapi verleiht APIs Superkräfte mit MCP

Model Context Protocol: Ein umfassender Leitfaden, wie es funktioniert und wie OpenAPI es nutzt, um APIs noch zugänglicher zu machen.

Das Model Context Protocol (MCP) ist derzeit der Hype in der Tech-Welt – und darüber hinaus. Es wird überall diskutiert: in GitHub-Repositories, auf YouTube-Videos und als zentrales Thema auf zahlreichen Veranstaltungen. Aber was genau ist MCP – und warum könnte es tatsächlich ein Game-Changer für die Welt der Künstlichen Intelligenz sein?

Was ist das Model Context Protocol (MCP)?

Das Model Context Protocol ist ein Open-Source- und Open-Standard-Protokoll, das im November 2024 von Anthropic eingeführt wurde – einem führenden Unternehmen im Bereich KI und direktem Konkurrenten von OpenAI, bekannt durch seine LLMs Claude.

Das Thema MCP erlangte jedoch erst einige Monate später, Anfang 2025, größere Aufmerksamkeit – vor allem durch das wachsende Interesse an KI-Agenten sowie durch öffentliche Aussagen von bekannten Tech-CEOs wie Sam Altman und Sundar Pichai zur Nutzung des MCP.

MCP wurde entwickelt, um ein sehr konkretes Problem zu lösen: die Qualität und Relevanz der Antworten von großen Sprachmodellen (LLMs) zu verbessern, die oft unter mangelndem Kontext leiden und dadurch fehlerhafte oder irrelevante Antworten liefern (sogenannte Halluzinationen).

Das Protokoll definiert einen universellen Standard, wie Anwendungen Kontext an LLMs übergeben können – und erleichtert so die Kommunikation zwischen KI-Modellen, datenbasierten Anwendungen, Business-Tools und Entwicklungsumgebungen. Deshalb wird MCP oft als das „USB-C der KI“ bezeichnet.

Wie funktioniert MCP?

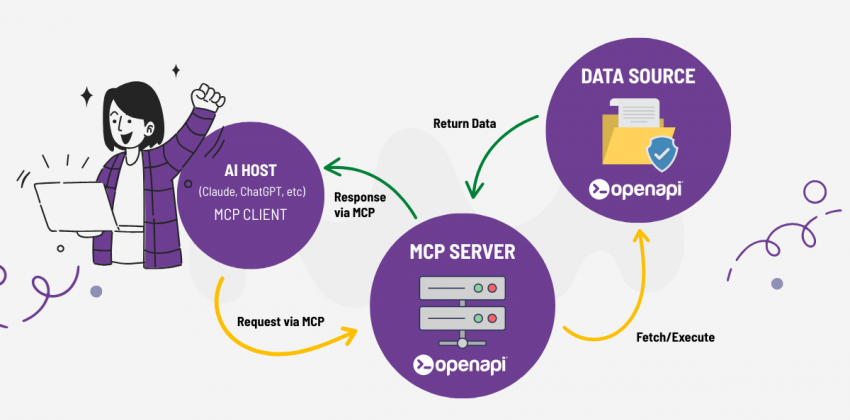

Wie bereits erwähnt, ist MCP ein Standard, der es Entwicklern ermöglicht, Verbindungen zwischen Datenquellen und KI-Werkzeugen herzustellen. Diese Werkzeuge können entweder über MCP-Server Daten bereitstellen oder als MCP-Clients Anwendungen erstellen, die auf diese Server zugreifen.

MCP basiert auf einer einfachen, modularen Client-Server-Architektur:

-

LLM: Das große Sprachmodell, das Nutzereingaben und zusätzlichen Kontext verarbeitet

-

MCP-Host: Die Anwendung, die das LLM hostet

-

MCP-Client: Eine Komponente, die 1:1-Verbindungen zu MCP-Servern aufrechterhält und den Kontext an das LLM weitergibt

-

MCP-Server: Ein Dienst, der Daten, Tools oder Funktionen über MCP bereitstellt

Der MCP-Server kann sicher auf Dateien, Datenbanken oder Onlinedienste (z.?B. GitHub oder externe APIs) zugreifen und diese Informationen in einem standardisierten Format an den MCP-Client weitergeben, der sie wiederum dem LLM übermittelt, um den Kontext zu erweitern und die Antwort zu verbessern.

Warum MCP für Entwickler wichtig ist

Vor MCP mussten KI-Modelle und Anwendungen jede einzelne Datenquelle oder jedes Tool separat integrieren – ein aufwändiges „M×N“-Integrationsproblem (M = Anwendungen, N = Datenquellen). MCP vereinfacht dieses Szenario radikal zu einem „M+N“-Problem – was die Entwicklung deutlich effizienter macht.

Entwickler müssen keine individuellen Schnittstellen mehr für jede Quelle oder jedes Modell erstellen – sie können Agenten und Workflows auf höherer Ebene bauen. Sie können problemlos zwischen KI-Modellen und Tools wechseln, ohne den Code neu schreiben oder an einen Anbieter gebunden sein zu müssen.

MCP vs API: Was ist der Unterschied?

MCP und REST-APIs scheinen ähnlich – beide ermöglichen Anfragen an externe Dienste. Aber es gibt grundlegende Unterschiede.

Ein wesentlicher Unterschied liegt in der Art der Anfrage und der Reaktion.

Eine REST-API verwendet definierte Endpunkte mit festen Parametern und gibt strukturierte Antworten zurück – aber ohne jede Interpretation.

MCP hingegen erlaubt Anfragen in natürlicher Sprache (Prompts) und liefert zusätzlichen Kontext an das LLM, sodass es zielgerichtet entscheiden kann, wann und warum ein Tool verwendet werden sollte.

Ein weiterer wichtiger Unterschied: MCP ist sitzungsorientiert – es ermöglicht KI-Agenten persistente, kontextreiche Dialoge mit Backend-Diensten.

Im Gegensatz zu zustandslosen REST-APIs unterstützt MCP:

-

Sitzungsspeicher zwischen Interaktionen

-

Strukturierte Tool-Aufrufe für komplexe Operationen

-

Streaming-Unterstützung per Server-Sent Events (SSE) oder HTTP

APIs können aber natürlich Bestandteil der Tools sein, die ein MCP-Server bereitstellt. Wenn ein LLM z.?B. ein Tool auswählt, kann dieses eine API-Anfrage ausführen und die Antwort dem LLM zurückliefern.

Anwendungsfälle von MCP: Von GitHub bis Salesforce, Postman und Canva

Der Einsatz von MCP eröffnet außergewöhnliche Möglichkeiten – auch außerhalb technischer Bereiche.

Entwickler können mithilfe von KI-Agenten Code überprüfen und schreiben, direkt mit GitHub interagieren, Fehler erkennen, Debugging durchführen oder sich wiederholende Aufgaben automatisieren.

Doch das Potenzial reicht weit über die Softwareentwicklung hinaus: MCP kann z.?B. für die Erstellung technischer Inhalte, den Kundensupport oder den Zugriff auf technische Dokumentation eingesetzt werden.

In den letzten Wochen haben mehrere Unternehmen die MCP-Integration angekündigt:

-

Salesforce: vereinfacht den sicheren Zugriff auf CRM-Daten über KI-Agenten, ohne Lizenz oder Schulung. Entwickler können Aufgaben wie Deployments, Queries und Tests mit intelligenten Prompts automatisieren. IT-Verantwortliche profitieren von zentralem Governance-Management für Richtlinien, Zugriffsrechte und Sicherheit über alle MCP-Connectoren hinweg.

GitHub: nutzt MCP zur Automatisierung von Code-Aufgaben, Integration externer Tools im Kontext sowie zur Aktivierung von cloudbasierten Workflows, die geräteübergreifend funktionieren.

-

Postman: bietet nun eine visuelle Erstellung von MCP-Agenten – ganz ohne Servercode oder Hosting. Mit nur einem Klick kann der Agent gestartet und direkt getestet oder mit der Agent Mode-Funktion verbunden werden.

-

Canva: dank MCP wird es bald möglich sein, Canva-Projekte direkt im Chat zu erstellen und zu bearbeiten. Ein einfacher Befehl genügt, um Präsentationen zu generieren, Designs anzupassen oder Ressourcen zu importieren – ohne die Unterhaltung zu verlassen.

Wie Openapi MCP in seine Anwendungen integriert

Wir freuen uns, eine bedeutende Weiterentwicklung bei Openapi anzukündigen:

Unser Technikteam arbeitet derzeit an einem Openapi-Server auf Basis des Model Context Protocol (MCP) – einer der innovativsten Technologien im Bereich KI und API-Integration.

Dank dieser neuen Infrastruktur können KI-Anwendungen in Echtzeit mit unserer API-Bibliothek interagieren, komplexe Anfragen natürlich, kontextbasiert und vollständig automatisiert stellen. Das bedeutet zum Beispiel:

-

Zugriff auf über 400 API-Dienste und Millionen von Datensätzen mit einer einfachen Text-Eingabe

-

Dynamisches Generieren, Filtern und Anreichern von Informationen

-

Intelligente Workflows mit externen Systemen integrieren – ohne komplexen Code

-

KI-gestützte, dialogfähige Agenten bei API-gestützten Aufgaben einsetzen

Der MCP-Server von Openapi wird neue Anwendungsfälle für unsere APIs ermöglichen, die Integration in KI-Systeme vereinfachen und Entwicklung, Test und Automatisierung beschleunigen.

In Kürze veröffentlichen wir weitere Details zu Release-Termin, technischer Dokumentation und den ersten verfügbaren Integrationen.